Was ist HDR? Was du über das Video-Upgrade wissen musst!

Bild: Dolby

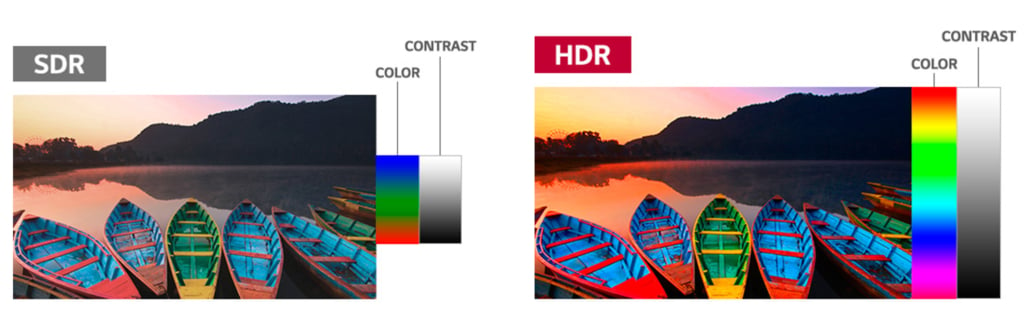

Bild: DolbyDie Abkürzung HDR steht für High Dynamic Range (also hohen Dynamik-Umfang) und ist neben der 4K-Auflösung aktuell das Upgrade für Videoinhalte bei Fernsehern schlechthin. Der Gegenbegriff zu HDR ist SDR, was für Standard Dynamic Range, den herkömmlichen Dynamik-Umfang, steht. Doch was bringt dir HDR eigentlich? Unser Ratgeber hilft dir auf die Sprünge.

High Dynamic Range: mehr Helligkeit, mehr Farben

Die High Dynamic Range soll für noch bessere Bilder sorgen, mit mehr Helligkeit, Kontrast und Farben. HDR erhöht die Helligkeitsspanne der Bilder. Das heißt, dass bei HDR-Content helle Bildbereiche wesentlich heller und dunkle Bildbereiche richtig dunkel dargestellt werden. Damit vervielfacht sich der verfügbare Spielraum für Helligkeit und Kontrast. Und was ist mit den Farben? HDR hat gleichzeitig einen größeren Farbumfang als SDR, sodass etwa ein intensives Rot satter und tiefer leuchten kann.

Natürlichere Bilder mit HDR?

Mit HDR nähert sich die verfügbare Technik weiter den Farben an, die in der Natur vorkommen, und die Menschen sehen können. Theoretisch also beste Voraussetzungen für lebensechte, natürlich wirkende Bilder. In Dokus wie Planet Erde II auf 4K-Blu-ray ist das auch sehenswert umgesetzt.

Auf der anderen Seite verschafft HDR den Filmschaffenden neue und bessere Möglichkeiten, Szenen dramatischer und spannender zu gestalten. Dann steht die Natürlichkeit hinter der Atmosphäre und dem künstlerischen Ausdruck zurück. Daher sind auch düstere HDR-Produktionen keine Seltenheit bei Kino-Filmen und einigen Serien.

Mehr Bits für feine Nuancen

Der digitale Standard für SDR bringt es auf bis zu 16,77 Millionen mögliche Farben, indem die Farbkanäle mit einem 8-Bit-System codiert werden. Nur mit zwei Bit mehr – also 10 Bit – kommt HDR auf über eine Milliarde Farbtöne. Die sogenannte „Farbtiefe“ von acht, zehn oder sogar zwölf Bit entscheidet also darüber, wie viele feine Farbnuancen sich darstellen lassen.

Damit kommt HDR dem, was das menschliche Auge wahrnimmt, schon deutlich näher, als SDR das vermochte.

Der vielfach höhere Spielraum an Digitalwerten ist wichtig, um auch feine Unterschiede zwischen Farb- und Helligkeitsstufen zu erfassen. HDR mit 10 Bit Farbtiefe stellt feine Farbverläufe, zum Beispiel im Blau des Himmels, ohne sichtbare Stüfchen dar. Auch Nuancen in dunklen Schatten und feingezeichnete helle Wolken stellt ein 10-Bit Bild genauer dar als ein 8-Bit-SDR-Bild.

HDR10: Der Basis-Standard für HDR-Fernseher

Damit HDR funktioniert, benötigt es einen neuen Standard für die Produktion, bei der Übertragung sowie beim Abspielen.

Die am häufigsten eingesetzte Technologie ist HDR10. Das steht für HDR mit 10 Bit Farbtiefe. 1000 Nits sind die gängige Spitzenhelligkeit für HDR10. Alle HDR-tauglichen Fernseher unterstützen HDR 10 als Basistechnik. Zudem lassen sich andere HDR-Formate wie Dolby Vision und HDR10+ in aller Regel auch in HDR10 abspielen.

Die Technik ist offen nutzbar und wird von allen Herstellern sowie Content-Anbietern und Medien (Netflix, Amazon Prime Video, Blu-ray und so weiter) unterstützt.

Statische Metadaten bei HDR10

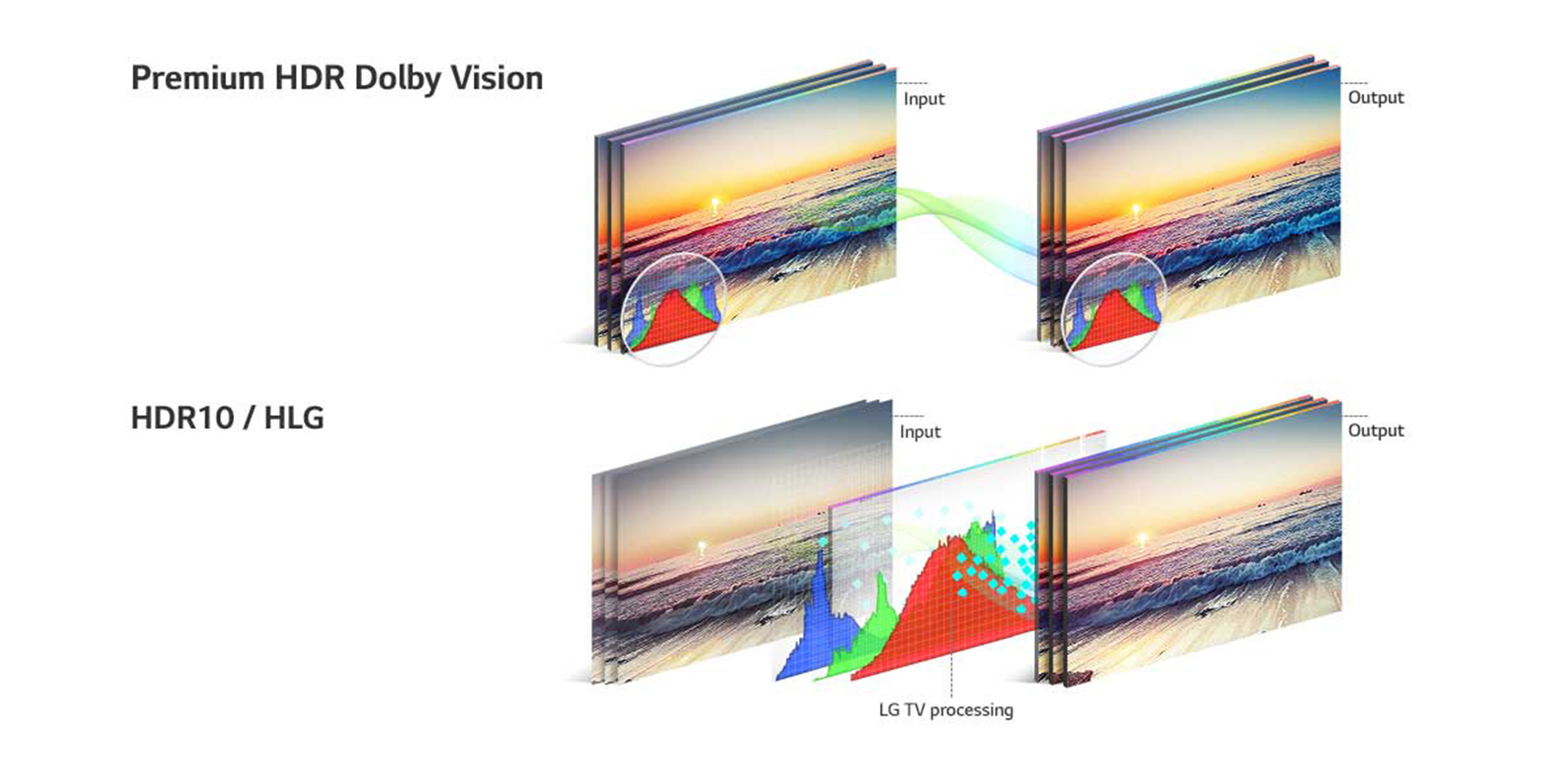

Alle nötigen Informationen über Helligkeit und Farben der HDR-Bilder sind in Metadaten – sozusagen digitalen Zusatzinformationen – niedergelegt. Bei HDR10 betreffen diese Metadaten jeweils den ganzen Film oder die ganze Folge einer Serie. Da sie sich während des Films nicht ändern, heißen sie Statische Metadaten.

Hier ein HDR10 Demo-Video auf YouTube. Aber Achtung: Ob du hier wirklich HDR siehst, hängt von deinem Browser und deinem Bildschirm ab. So bekommst du heraus, ob du HDR siehst oder nicht: Wenn du auf das Video rechtsklickst und „Statistik für Interessierte“ auswählst, steht im Falle von HDR-Wiedergabe unter „Color“ bt2020, sonst bt709. In dem Fall siehst du eine von YouTube auf SDR umkodierte Version.

Andere HDR-Verfahren ermöglichen dagegen unterschiedliche Zusatzinformationen für einzelne Szenen oder sogar für einzelne Bilder. Dann spricht man von „dynamischen Metadaten“ – sie kommen bei den HDR-Verfahren Dolby Vision und HDR10+ zum Einsatz.

Dolby Vision: Die Lizenz für Premium-HDR

Dolby Vision gilt als Premium-HDR-Technik. Der große Vorteil gegenüber HDR10 ist, dass Metadaten bei Dolby Vision in der Produktion für jede Szene oder gar jeden Frame hinterlegt werden können, was eine unterschiedliche Bildoptimierung für dunkle und helle Szenen ermöglicht. Für die Nutzung seines Standards verlangt Dolby allerdings eine Gebühr von Herstellern und Anbietern.

Netflix ist einer der Dienste, die bei ihren Eigenproduktionen Dolby Vision unterstützen. Auch Amazon bietet einige Titel mit dem Standard an, ebenso verschiedene UHD-Blu-rays. Jedoch ist HDR10 im Disc-Bereich aktuell noch deutlich verbreiteter, was sicherlich auch mit der Gebührenfreiheit zusammenhängt.

HDR10 und Dolby Vision existieren bei Content-Diensten wie auch bei TV-Geräten problemlos nebeneinander. Das ist etwa bei Netflix und Amazon der Fall – TV-Geräte mit Dolby Vision unterstützen immer auch HDR10. Fast alle TV-Hersteller haben Modelle im Sortiment oder angekündigt, die Dolby-Vision-Support mitbringen, Samsung geht hingegen einen eigenen Weg.

HDR10+: Samsungs eigener Standard

Anstatt sich des Dolby-Standards zu bedienen, hat TV-Hersteller Samsung seine eigene HDR-Technologie mit dynamischen Metadaten herausgebracht. Es handelt sich um „HDR 10+“. Gravierende Qualitätsunterschiede zwischen HDR10+ und Dolby Vision lassen sich dabei aktuell nicht erkennen. Im Gegensatz zu Dolby Vision fallen für die TV-Hersteller bei Samsungs HDR-Verfahren keine zusätzlichen Lizenzkosten an. HDR10+ konnte sich so neben Dolby Vision etablieren und wird unter anderem von Amazon Prime unterstützt. Streaming-Pionier Netflix setzt hingegen auf Dolby Vision.

Dabei bieten nicht nur Samsung-Fernseher die passende Hardware für HDR10+. Auch Philips, Panasonic, Hisense und TCL haben entsprechende Modelle im Sortiment. Anders als Samsung unterstützen diese zum Teil neben HDR10+ auch Dolby Vision.

Der nächste Schritt: Dolby Vision 2 und Samsungs HDR10+ Advance

Dolby Vision fängt im Filmstudio an und endet in Dolby-Vision-Fernsehern. Das Unternehmen hat 2025 mit Dolby Vision 2 eine Erweiterung der Technik angekündigt, die noch mehr Hilfen für die Fernseher geben soll. Unter anderem eine Optimierung des Schwarzwertes und neue Metadaten, die helfen, nerviges Ruckeln von Kameraschwenks gezielt zu vermindern. Samsung zieht mit einem vergleichbaren System unter der Bezeichnung HDR10+ advance in der HDR-Entwicklung nach.

Allerdings gibt es bislang noch keine nennenswerten Film- oder TV-Produktionen hierfür. Immerhin soll sich Canal+ aus Frankreich für Produktionen in Dolby Vision 2 interessieren.

HLG: Das HDR fürs TV-Programm

Mit den bisher behandelten Standards ist es nicht möglich, lineares TV-Programm mit HDR auszustrahlen. Hier kommt Hybrid Log Gamma, kurz HLG, ins Spiel. HLG ermöglicht die Darstellung von TV-Sendungen oder Live-Übertragungen von Sport-Ereignissen in besserer Bildqualität.

4K-TVs sind heutzutage HLG-ready, jedoch kommen die Inhalte nur allmählich. Der von den Sendern BBC (Großbritannien) und NHK (Japan) entwickelte Standard ist bislang der einzige für HDR-Fernsehen. Über Satellit gibt es die ersten UHD-Sendungen mit HDR zu sehen. Ein Anbieter ist HD+, das HD-Angebot von den großen Privatsendern wie RTL, SAT.1 und Co., das über ASTRA 19.2° Ost abgestrahlt wird.

Worauf solltest du beim TV-Kauf achten?

Beim TV-Kauf sollte man darauf achten, dass HDR10 und entweder Dolby Vision oder HDR10+ unterstützt werden. Beispielsweise mit den OLED-TVs OLED810 von Philips und Mini-LED-Fernsehern wie TCL C7K gibt es aber auch Fernseher, die sowohl HDR10+ als auch Dolby Vision unterstützen. Für bestmögliche HDR-Bilder sind eine hohe Spitzenhelligkeit von mindestens 1000 Nits und eine sehr gute Signalverarbeitung wichtig.

Alle HDR-Formate existieren friedlich nebeneinander. In der Bildqualität macht es dabei einen größeren Unterschied, ob du einen OLED, einen Mini-LED-TV oder einen einfachen QLED-TV kaufst, als welches HDR-Format abgespielt wird.

HDR-Studiomonitore wie der „Pulsar“ von Dolby können mit bis zu 4000 Nits (Einheit der Leuchtdichte) um ein Vielfaches heller sein als herkömmliche LED-TV-Modelle (maximal etwa 600 Nits). Sehr gute HDR-TVs schaffen Spitzenhelligkeiten von über 2000 Nits, wie etwa der Sony Mini-LED Bravia 9, der QD-OLED Samsung S95F oder der LG G5.

Die allgemeine Angabe „HDR“ bei TV-Geräten sagt zunächst nur aus, dass HDR-Bildsignale störungsfrei wiedergegeben werden. Die preiswertesten HDR-fähigen Fernseher sind allerdings nur wenig heller oder kontraststärker als herkömmliche Fernseher ohne HDR. Damit bekommst du nur eine Andeutung dessen, was HDR bringt, zu sehen.

Die besten HDR-Bilder bringen derzeit OLED-TVs und QLED-TVs. Mehr zu den Unterschieden von QLED und OLED sowie Vor- und Nachteilen erfährst du in unserem Ratgeber über Display-Technolgien.

HDR-Referenzvideo im Netz

Wenn du dir selbst ein Bild davon machen möchtest, wie dasselbe Videomaterial in HDR10, HDR10+ und Dolby Vision aussieht, solltest du mal die Internetseite von Le Labo de Jay besuchen. Dort findest du HDR-Referenzvideos, an deren Erstellung auch der Bildexperte Florian Friedrich mitgewirkt hat. Die Unterschiede zwischen den HDR-Verfahren stecken allerdings tatsächlich in Feinheiten, die unter Umständen von den Eigenschaften deines TV-Geräts überdeckt werden.

2 Kommentare

Diskutiere mit »Damit du kommentieren kannst, logge dich ein mit deinen Hifi-Forum-Zugangsdaten oder registriere dich hier kostenlos.

Wie zukunftssicher ist HDR10+ denn?

Ich möchte mir einen 4K Fernseher zulegen und habe zurzeit den Samsung Q95T in der engeren Auswahl. Dieser bietet leider kein Dolby Vision. Ein OLED kommt für mich nicht in Frage. Da nur QLED an die Bildqualität von OLED herankommt, gibt es nur Samsung zur Auswahl, welche allerdings auf ihren eigenen Standard setzen. Ist man mit HDR10+ für die nächsten 5 bis 10 Jahre gesichert oder sollte doch eher auf Dolby Vision gesetzt werden?

Wir gehen davon aus, dass HDR10+ nicht vom Markt verschwinden wird, doch es gibt mehr Inhalte mit Dolby Vision. QLED TVs von Samsung geben Dolby Vision als HDR10 sauber wieder. Wir haben aktuell einen Q95T im Test, und überprüfen auch, wie Dolby-Vision-Inhalte auf dem lichtstarken QLED (als HDR10) herauskommen.